В предыдущих главах мы обсуждали, как скрасить веб -сайт HTML Информацию и магазин информации о продукте через JSON API. На самом деле, на большинстве веб -сайтов и платформ существует более одной страницы, чтобы показать статьи, продукты и так далее. По сути, мы называем это страницей. Например, страница 1 или предыдущая страница, или следующая страница, а также предыдущие коды и только набор данных могут соскрестить единый URL -страницу.

В этой статье я бы проведет вас через то, как соскрести веб -страниц и магазин продуктов, используя Asy2digital API. Это для захвата всех целевых наборов данных оптом. К концу этой статьи вы можете освоить библиотеку Pandas и некоторые новые методы. Кроме того, вы можете настроить сценарий на основе потребностей вашего бизнеса.

Соглашение: Создайте бот Shopify, чтобы соскребить данные о продукте в масштабе, используя Asy2digital API

- Импортные модули

- Определите структуру URL -адреса на стратегии

- Написать строки кода, чтобы очистить целевой набор данных

- Добавить набор данных

- Сохранить набор данных в формате Excel с использованием методов DataFrame и TO_CSV

- Easy2digital API — Shopify Scream

- Бесплатный Easy2digital API бесплатный токен и полный сценарий Python Shopify Scraper

- Shopify Последняя рекомендация API API API

Импорт модулей для соскоб

We would use bs4, requests, and Pandas library in this script. As we would take Shopify as the other example as well, so we need to import JSON

Pandas-быстрый, мощный, гибкий и простой в использовании инструмент анализа и манипуляции с открытым исходным кодом. Он построен на вершине языка программирования Python. Довольно полезно реструктурировать набор данных и сохранить его в формате CSV.

Определите структуру URL -адреса на стратегии

Я принимаю папку блога Easy2digital в качестве первого примера. Как вы можете видеть из пути блога, номер после страницы/ местоположение страницы обратной страницы страницы страницы за обратной страницей. Таким образом, мы можем создать переменную, которая может быть после страницы и изменить, петля соответственно соскребтировать

Вот код, где мы устанавливаем страницу как «X», и мы используем цикл «для», функция диапазона и STR.

Range function actually creates a sequence of numbers from 0 to N, and prints each item in the sequence. In this case, we can set a number like 20, and this number is already more than my blog pagination pages. I recommend

Функция STR () Python возвращает строковую версию объекта. Это гарантирует, что возврат является строкой.

И последнее, но не менее важное: нам нужно создать переменную с пустым значением в данный момент, которая используется для генерации всего набора данных скребки в конце.

Если нам придется скраснуть через API платформы, например, Shopify, ниже приведены кодирование, например, на другой веб -сайт — Wasserstein Home

В API Shopify Frontend Product структура JSON такая, где на каждой странице есть не более 250 элементов данных о продукте. Параметр страницы представляет значение страниц

Таким образом, это очень похоже на страстную страницу HTML Pagination, но просто нужно скрепить через API платформы

Написать строки кода для очистки целевых наборов данных

Теперь мы уже соскребили данные блока, и пришло время найти, какие данные нам нужны.

Ниже приведен пример блога Easy2digital для вашей ссылки. Для получения более подробной информации, пожалуйста, ознакомьтесь с другой статьей, потому что мы говорили об этом ранее.

Глава 4: Создайте бот веб -сайта для очистки конкретных данных веб -сайта с помощью BeautifulSoup

Добавить набор данных по скребке Web

Ранее в модуле CSV и в Google мы говорили о том, как добавить набор для соскоб. Здесь мы используем библиотеку Pandas, которая удобнее манипулировать данными в строке и столбце

Во -первых, мы создаем переменную для определения имени набора набора данных. Затем мы можем добавить функцию, и данные могут быть организованы в отдельный столбец с уникальным именем головки, определенным в element_info

Then we use the len() function, in order to show how many pieces you can scrape, and the number helps you understand if the dataset size makes sense or not.

Сохранить набор данных в формате Excel с использованием методов DataFrame и TO_CSV

Те, кто знаком с R, знают кадр данных как способ хранить данные в прямоугольных сетках, которые можно легко обзор. Каждая строка этих сетей соответствует измерениям или значениям экземпляра. И каждый столбец представляет собой вектор, содержащий данные для определенной переменной. Это означает, что строки кадра данных не должны содержать, но могут содержать, одинаковый тип значений: они могут быть числовыми, символами, логическими и т. Д.

DataFrames в Python очень похожи, они поставляются с библиотекой Pandas, и они определяются как двумерные маркированные структуры данных с столбцами потенциально разных типов. В общем, вы могли бы сказать, что DataFrame Pandas состоит из трех основных компонентов: данных, индекса и столбцов.

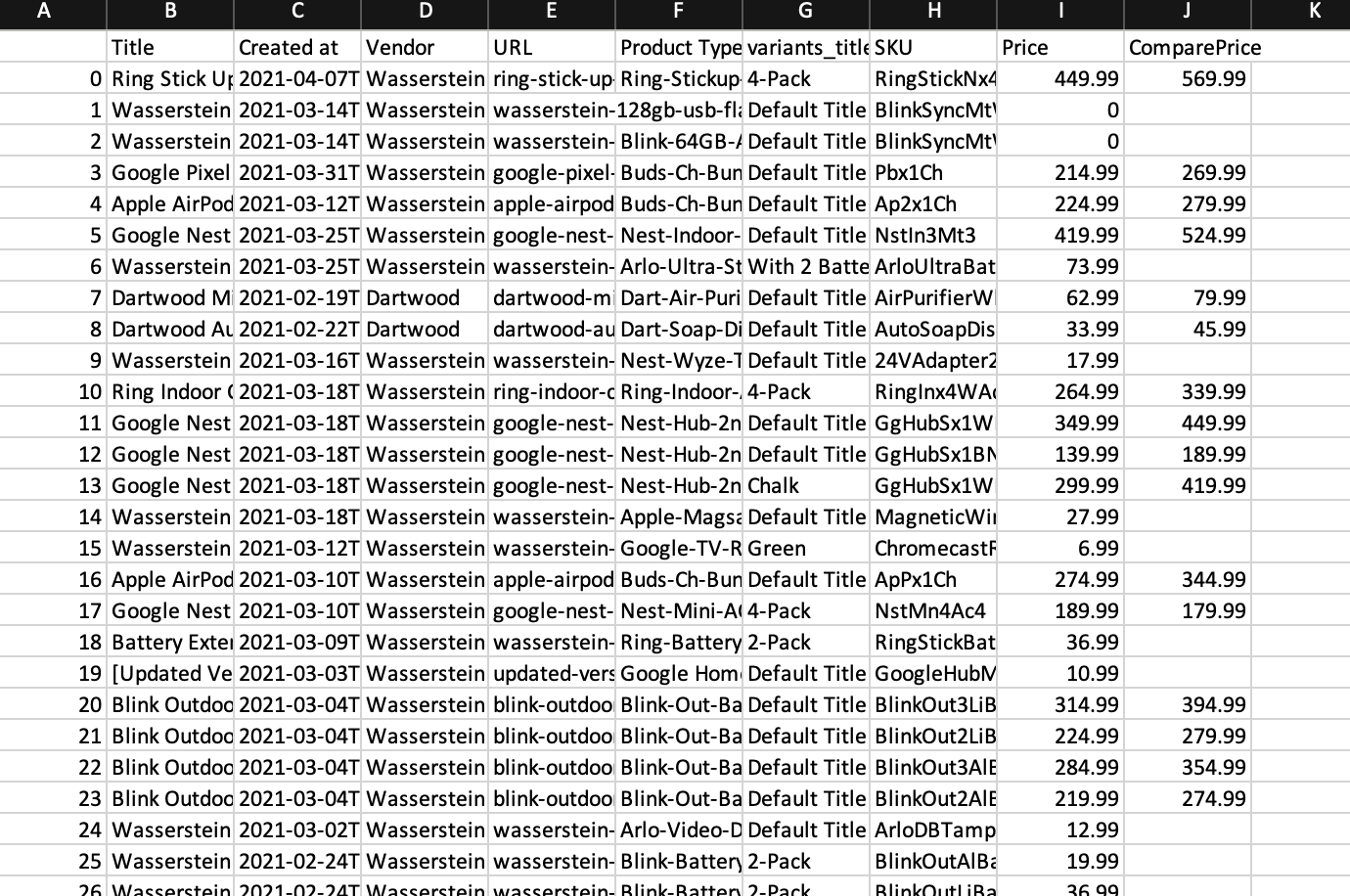

Мы используем функцию Frame Data и функцию TO_CSV, то есть вместе с библиотекой Pandas, ниже приведен окончательный сценарий скребка Product Product Product Product и сгенерированный файл Excel

Используйте easy2digital API — Shopify Scream

Если вы обнаружите, что сценарий может быть сложным, а также потребует, чтобы вы обновляли сценарии и исправляли ошибки, вы можете использовать ASPI ASPIS Shopify Shopify Product Scify API. Вот конечная точка токена следующим образом:

https://www.buyfromlo.com?token=&ysiteURL=&protocal=

By using this API endpoint, you just need to add the Easy2Digital token, the target shop domain brand name, and the type of top-level domain or subdomain (www, us, HK, etc) you aim to scrape. The scraped result is the same as the one shown above.

Для получения более подробной информации о маркетинговых API, пожалуйста, ознакомьтесь с этой страницей.

Полный сценарий Python Shopify скрещивания подачи продуктов.

If you would like to have a free API token and the full version of the Python Script of Shopify Bot, please subscribe to our newsletter by adding the message Python Tutorial 10. We would send you asap to your mailbox.

Так легко, верно? Я надеюсь, что вам понравится читать главу 10 — постройте бот Shopify, чтобы очистить данные о продукте магазина, используя easy2digital API. Если вы это сделали, пожалуйста, поддержите нас, делая одну из перечисленных ниже вещей, потому что это всегда помогает нашему каналу.

- Support and donate to our channel through PayPal (paypal.me/Easy2digital)

- Subscribe to my channel and turn on the notification bell Easy2Digital Youtube channel.

- Follow and like my page Easy2Digital Facebook page

- Поделитесь статьей в вашей социальной сети с хэштегом #Easy2digital

- Buy products with Easy2Digital 10% OFF Discount code (Easy2DigitalNewBuyers2023)

- Вы регистрируетесь на нашем еженедельном информационном бюллетене, чтобы получить последние 2 -дигитальные последние статьи, видео и коды дисконтов

- Subscribe to our monthly membership through Patreon to enjoy exclusive benefits (www.patreon.com/louisludigital)

Глава 11: Google Serp Bot, чтобы очистить данные Serp, используя Google Search и Easy2digital API

Shopify API Endpoint Рекомендация

Shopify Product Scraper API

Цена: 5 долларов США

Сократите информацию о продуктах из любого веб -магазина, созданного с использованием платформы Shopify. Сокращение продукта до 500 Skus. 15+ Метрики данных о продукте включены в скрещенные результаты, которые включают цены, DATE_CREATED, название продукта и т. Д. И поддержка для соскребания эфира верхнего домена или субдомена Shopify Domain

Больше вариантов API из коллекции Shopify.

Сэкономьте до 50% и изучите больше!